Использование MCP-сервера ClickHouse с LibreChat

В этом руководстве объясняется, как настроить LibreChat с MCP-сервером ClickHouse с использованием Docker и подключить его к примерным наборам данных ClickHouse.

Установка Docker

Для запуска LibreChat и сервера MCP потребуется Docker. Чтобы установить Docker:

- Перейдите на docker.com

- Скачайте Docker Desktop для своей операционной системы

- Установите Docker в соответствии с инструкциями для вашей операционной системы

- Откройте Docker Desktop и убедитесь, что он запущен.

Для получения дополнительной информации см. документацию Docker.

Клонируйте репозиторий LibreChat

Откройте терминал (командную строку или PowerShell) и клонируйте репозиторий LibreChat с помощью следующей команды:

Создайте и отредактируйте файл .env

Скопируйте файл примера конфигурации из .env.example в .env:

Откройте файл .env в вашем текстовом редакторе. Вы увидите разделы для

многих популярных провайдеров LLM, включая OpenAI, Anthropic, AWS Bedrock и другие,

например:

Замените user_provided на ваш API-ключ провайдера LLM, который вы хотите использовать.

Если у вас нет API-ключа, вы можете использовать локальную LLM, например Ollama. Как это сделать, описано далее в шаге "Установка Ollama". Пока не изменяйте файл .env и продолжайте выполнение следующих шагов.

Создайте файл librechat.yaml

Выполните следующую команду для создания нового файла librechat.yaml:

Это создаёт основной файл конфигурации для LibreChat.

Добавление сервера ClickHouse MCP в Docker Compose

Теперь мы добавим сервер ClickHouse MCP в файл Docker Compose LibreChat, чтобы LLM мог взаимодействовать с ClickHouse SQL Playground.

Создайте файл с именем docker-compose.override.yml и добавьте в него следующую конфигурацию:

Если вы хотите исследовать собственные данные, вы можете сделать это, используя host, username и password вашего сервиса ClickHouse Cloud.

Настройка сервера MCP в librechat.yaml

Откройте librechat.yaml и добавьте следующую конфигурацию в конец файла:

Это настраивает LibreChat для подключения к серверу MCP, работающему на Docker.

Найдите следующую строку:

Для упрощения мы временно отключим необходимость аутентификации:

Добавление локальной LLM с помощью Ollama (опционально)

Установите Ollama

Перейдите на сайт Ollama и установите Ollama для вашей системы.

После установки можно запустить модель следующим образом:

Это загрузит модель на локальную машину, если она отсутствует.

Список моделей см. в библиотеке Ollama

Настройка Ollama в librechat.yaml

После загрузки модели настройте её в librechat.yaml:

Запуск всех сервисов

Из корневой директории проекта LibreChat выполните следующую команду для запуска сервисов:

Дождитесь полного запуска всех сервисов.

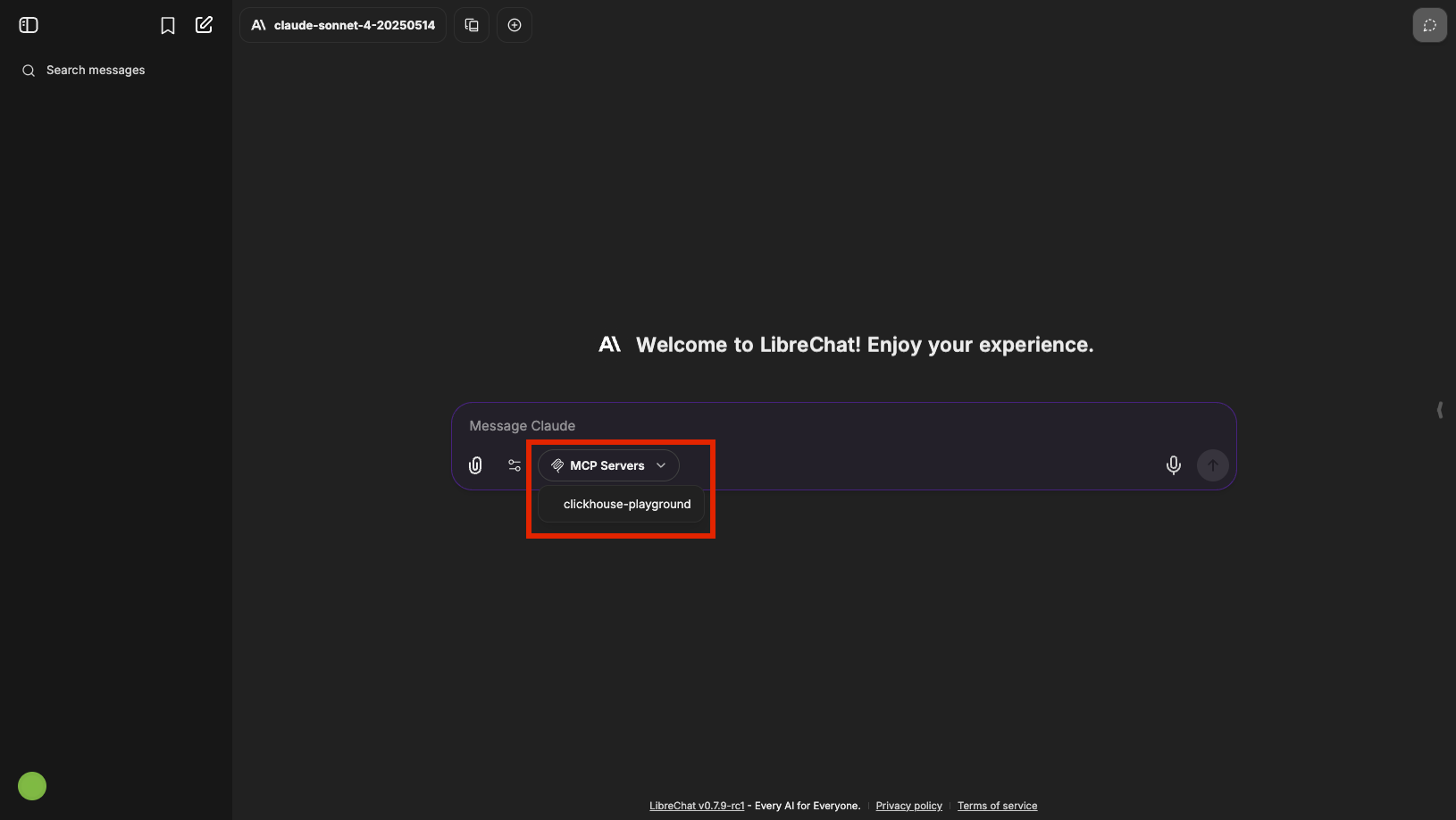

Откройте LibreChat в браузере

После того как все сервисы запущены и работают, откройте браузер и перейдите по адресу http://localhost:3080/

Создайте бесплатный аккаунт LibreChat, если у вас его еще нет, и войдите в систему. Теперь вы должны увидеть интерфейс LibreChat, подключенный к серверу ClickHouse MCP и, при необходимости, к вашей локальной LLM.

В интерфейсе чата выберите clickhouse-playground в качестве MCP-сервера:

Теперь вы можете предложить LLM исследовать примеры наборов данных ClickHouse. Попробуйте:

Если параметр MCP server не отображается в интерфейсе LibreChat,

убедитесь, что в файле librechat.yaml заданы корректные права доступа.

Если для use в разделе mcpServers внутри interface установлено значение false, выпадающий список выбора MCP не будет отображаться в чате: